当前,AI服务器的芯片构成为”CPU+加速芯片“,加速芯片主要有CPU、FPGA和ASIC等加速芯片,利用CPU与加速芯片的组合可以满足高吞吐量互联的需求,从而加速模型的训练(training)、推理(Inference)过程。

CPU中有大量的缓存和复杂的逻辑控制单元,擅长逻辑控制、串行运算,但CPU的算力小,不擅长复杂算法运算和并行运算,因此在AI模型的训练过程中需要加速芯片来加速大量数据的计算,加速算法的演进和模型的更新。

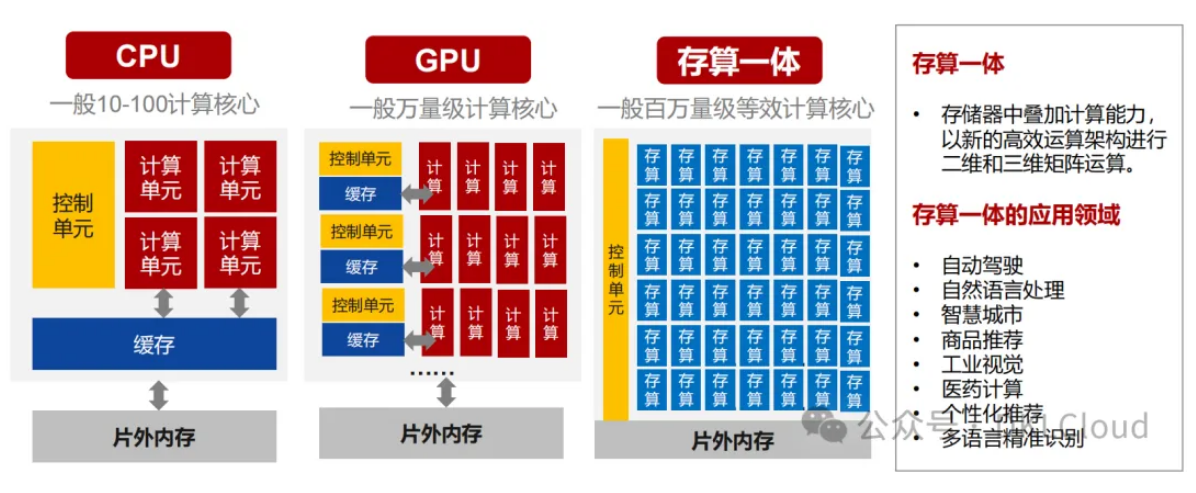

CPU以及加速芯片(GPU、存算一体芯片)的架构:

About 存算一体性芯片:大模型训练的过程是算法学习大数据中规律的过程,训练时间主要花费在数据处理(学习)和数据搬运(在device和host之间搬运数据)上,大模型的训练数据集往往非常庞大,存算一体芯片将计算单元需要的数据“放在自己身边”,减少芯片内外的数据搬运,从而提升了模型的训练效率。

不同AI加速芯片的优缺点:

| 芯片类别(chips category) | 优点(advantages) | 缺点(disadvantages) | 产品 |

|---|---|---|---|

| GPU | 支持大量并行计算(浮点运算能力) | 管理控制能力弱(CPU具备较强的管理控制能力),功耗高 | Nvidia A100、Nvidia H100等 |

| FPGA | 可重复编程、低延时、硬件可根据需求调整、灵活性最高 | 开发难度大、定点运算、价格贵 | Intel Arria 10等 |

| ASIC | 成本低、能耗低、性能强、针对AI设定特定架构 | 灵活性不够,价格高于FPGA | 谷歌TPU、华为昇腾910等 |